يشهد العالم تطورًا سريعًا في أنظمة الذكاء الاصطناعي، مما يزيد اعتمادها في مجالات عديدة مثل الطب، والسيارات ذاتية القيادة، والأنظمة المالية. لكن هذه التطورات تثير تساؤلات مهمة حول قدرتها على اتخاذ قرارات أخلاقية. هل يمكن للذكاء الاصطناعي أن يميز بين الصواب والخطأ كما يفعل البشر؟

يتناول هذا المقال مفهوم الأخلاق في الذكاء الاصطناعي، وإمكانياته في اتخاذ قرارات عادلة. كما يناقش معايير تطوير “أخلاقيات الذكاء الاصطناعي” والتحديات التي تواجه هذه العملية.

مفهوم الأخلاق في الذكاء الاصطناعي

تشير الأخلاق إلى المبادئ التي تحدد السلوك الصحيح. أما في الذكاء الاصطناعي، فتتمثل في القواعد التي توجه قرارات الأنظمة الذكية. لكن هذه الأنظمة لا تمتلك وعيًا ذاتيًا، بل تعتمد على البيانات والخوارزميات.

هناك نوعان رئيسيان من الأخلاق في الذكاء الاصطناعي:

- الأخلاقيات المدمجة: القيم والمعايير التي يضيفها المبرمجون إلى الخوارزميات.

- الأخلاقيات الناشئة: السلوكيات التي تظهر مع تعلم الآلة والتفاعل مع البيئة.

قدرة الذكاء الاصطناعي على اتخاذ قرارات أخلاقية

تعتمد قرارات الذكاء الاصطناعي على مدى تطور الخوارزميات ودقة البيانات المستخدمة. لضمان الالتزام بالأخلاقيات، يعتمد الباحثون على عدة طرق، منها:

- التعلم القائم على القيم: تدريب الأنظمة الذكية على محاكاة قرارات البشر الأخلاقية.

- التعلم العميق الموجه بالأخلاقيات: تدريب الشبكات العصبية على تقييم الخيارات أخلاقيًا.

- القواعد الصارمة: تزويد الذكاء الاصطناعي بإرشادات محددة لاتخاذ قرارات عادلة.

لكن هذه الطرق تواجه تحديات مثل تحيز البيانات، وعدم فهم السياقات الثقافية المتنوعة، وصعوبة برمجة القيم المجردة.

معايير تطوير “أخلاقيات الذكاء الاصطناعي”

تسعى شركات التكنولوجيا والمؤسسات البحثية إلى وضع إطار أخلاقي لتوجيه تطوير الذكاء الاصطناعي. تشمل هذه المعايير:

- الشفافية: يجب أن تكون الخوارزميات واضحة، مما يسمح بتدقيق قراراتها.

- العدالة وعدم التحيز: ينبغي تدريب الأنظمة على بيانات متنوعة لضمان قرارات عادلة.

- المساءلة: يجب تحديد المسؤوليات في حال حدوث أخطاء.

- الخصوصية وحماية البيانات: ينبغي احترام خصوصية المستخدمين وتجنب استغلال بياناتهم.

- المسؤولية الاجتماعية: يجب أن تساهم هذه الأنظمة في تحسين المجتمع بدلاً من استغلاله.

التحديات الأخلاقية التي تواجه الذكاء الاصطناعي

رغم الجهود المبذولة، لا تزال هناك تحديات تعيق تحقيق أخلاقيات الذكاء الاصطناعي، أبرزها:

- تحيز البيانات: تعتمد الأنظمة الذكية على البيانات التي تتعلم منها، مما قد يؤدي إلى قرارات غير عادلة.

- غياب الفهم العميق: الذكاء الاصطناعي يحلل الأنماط، لكنه لا يدرك القيم الأخلاقية بنفس طريقة البشر.

- المساءلة القانونية: يصعب تحديد المسؤول عن أخطاء الذكاء الاصطناعي.

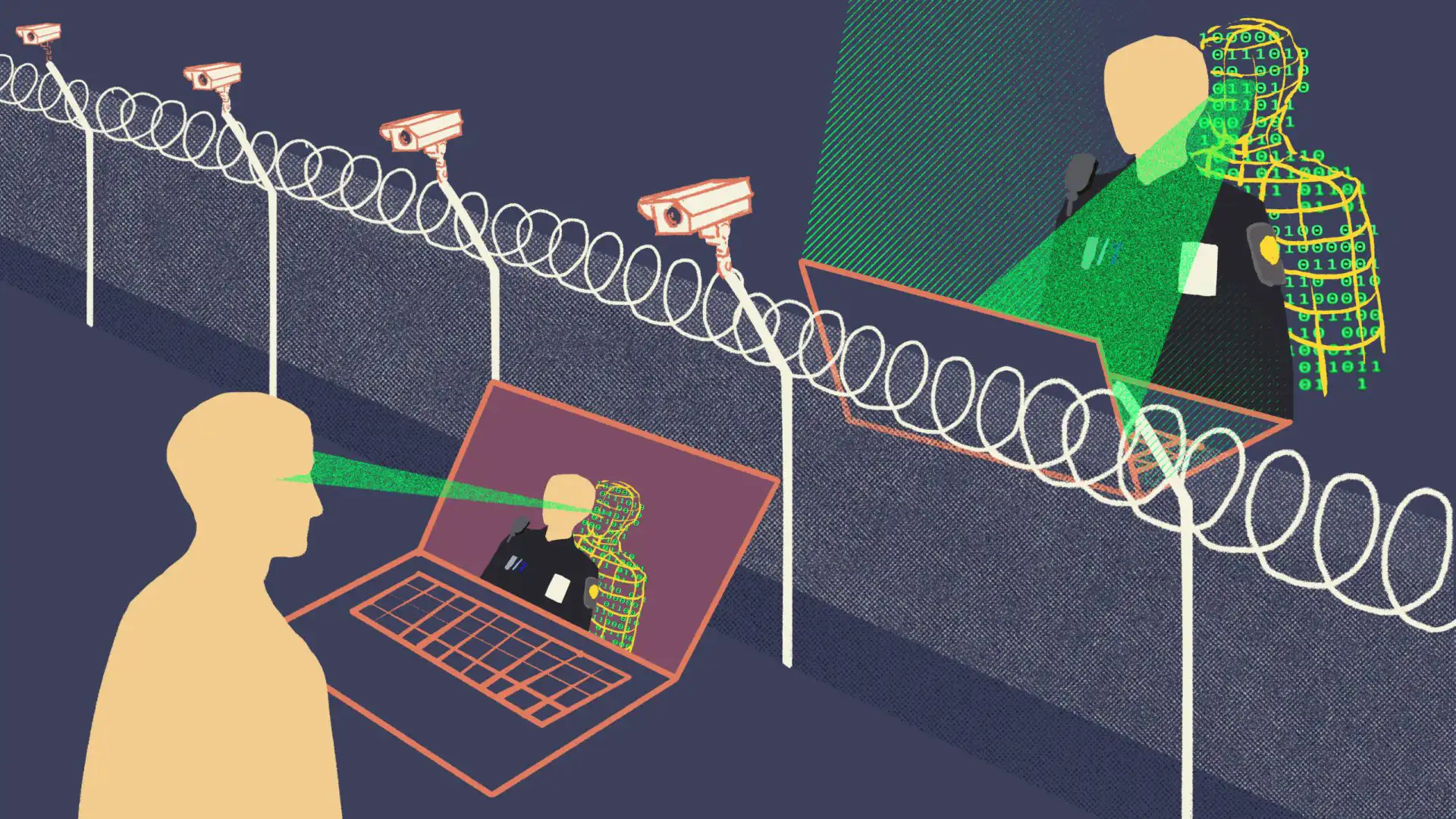

- إمكانية إساءة الاستخدام: يمكن استغلال الذكاء الاصطناعي في التجسس أو نشر المعلومات المضللة.

هل يمكن للذكاء الاصطناعي أن يكون أخلاقيًا؟

لا يمتلك الذكاء الاصطناعي وعيًا أخلاقيًا، لكنه يستطيع اتخاذ قرارات متوافقة مع القيم الإنسانية إذا تمت برمجته بشكل صحيح. التحدي الرئيسي يكمن في تطوير أنظمة تلتزم بالعدالة والشفافية وتحترم الحقوق الفردية.

يبقى دور البشر أساسيًا في توجيه الذكاء الاصطناعي لضمان اتخاذه قرارات مسؤولة. الأخلاقيات في الذكاء الاصطناعي ليست مجرد قضية تقنية، بل تحتاج إلى تعاون بين العلماء والمشرعين والمجتمع لضمان استخدامه بطريقة تحقق الفائدة للجميع.