من التزييف التقليدي إلى التزييف العميق

الأخبار الكاذبة ليست ظاهرة جديدة، لكنها اكتسبت بعدًا غير مسبوق مع ظهور تقنيات التزييف العميق (Deepfake).

باستخدام الشبكات العصبية التوليدية (GANs)، أصبح من الممكن إنشاء صور وفيديوهات وصوتيات تحاكي الواقع بدقة مذهلة.

هذه المواد لا تقتصر على الترفيه، بل تُستخدم أحيانًا لتشويه سمعة شخصيات عامة أو نشر روايات سياسية مزيفة.

الذكاء الاصطناعي هنا لا يكتفي بمحاكاة الحقيقة، بل يصنع بديلاً رقمياً عنها.

كيف يُنتج الذكاء الاصطناعي الأكاذيب المقنعة؟

تعتمد أنظمة التزييف العميق على تدريب نموذجين من الذكاء الاصطناعي يتنافسان:

أحدهما يُنشئ المحتوى المزيف، والآخر يحاول اكتشافه.

ومع كل دورة تدريبية، تتحسن دقة النموذج الأول حتى يصبح المحتوى الناتج شبه مطابق للواقع.

هذا التطور التقني جعل من السهل على الأفراد أو الجهات الموجهة إنتاج محتوى خادع بموارد محدودة، ما يضاعف خطر التضليل في الفضاء الإعلامي.

منصات التواصل كمسرح للتضليل الذكي

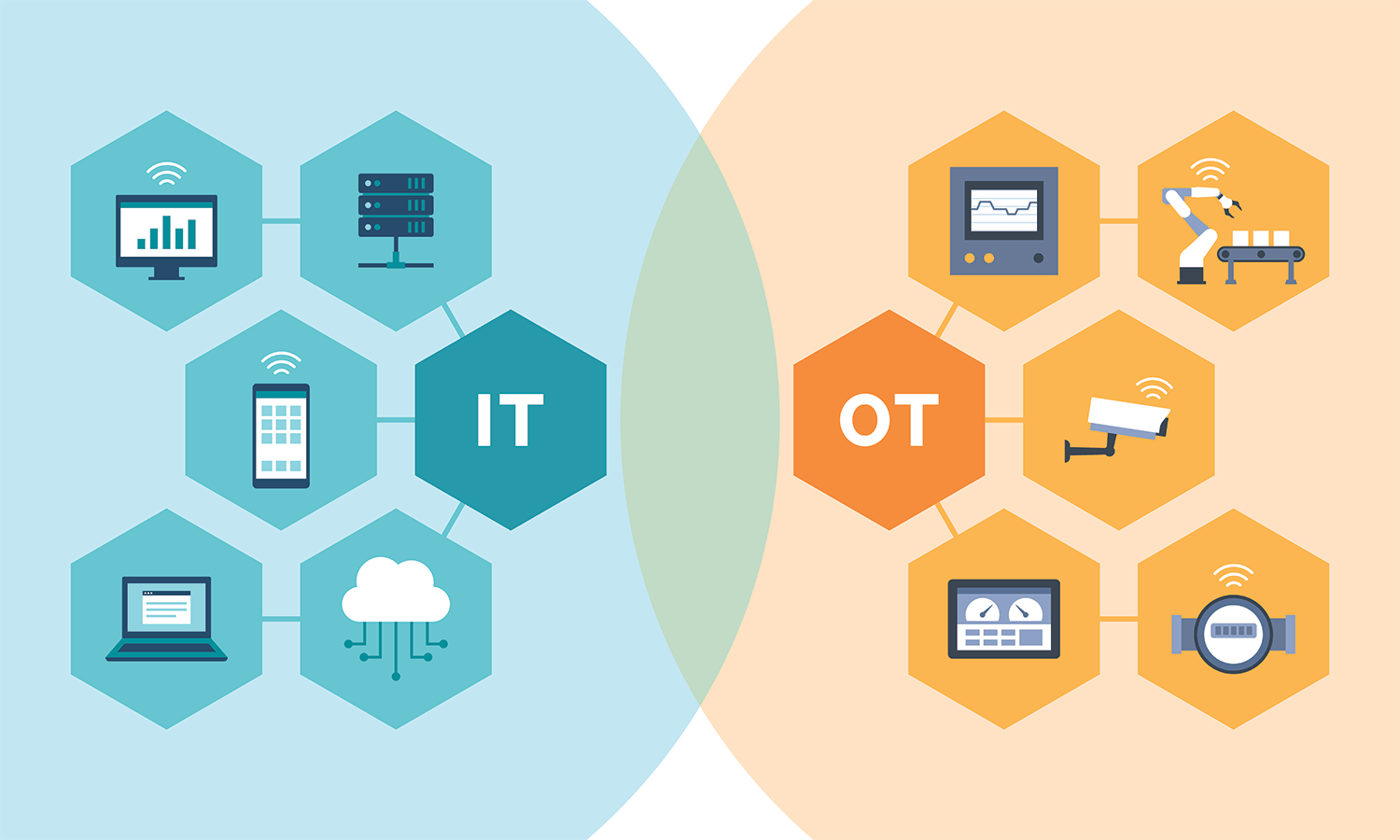

تُعتبر شبكات التواصل الاجتماعي البيئة المثالية لانتشار الأخبار المزيفة المدعومة بالذكاء الاصطناعي.

تُستخدم خوارزميات تحليل السلوك لتحديد الجمهور المستهدف، ثم تُرسل الرسائل الموجهة التي تثير مشاعر الغضب أو الخوف.

النتيجة شبكة من “الحقائق البديلة” تتغذى على التفاعل العاطفي لا على التحقق العقلي.

بهذا، يتحول الذكاء الاصطناعي من أداة تحليل إلى سلاح نفسي في إدارة الرأي العام.

التحقق الآلي: الذكاء الاصطناعي ضد نفسه

في مواجهة هذا الخطر، ظهر اتجاه معاكس يوظف الذكاء الاصطناعي لكشف الأخبار المزيفة.

تستخدم أنظمة التحقق الآلي (Automated Fact-Checking) تقنيات معالجة اللغة الطبيعية (NLP) لتحليل النصوص ومقارنتها بمصادر موثوقة.

كما تُستخدم خوارزميات تحليل الصور والفيديو لاكتشاف التلاعب في الإطارات أو الأصوات.

بهذا، تحوّل الذكاء الاصطناعي إلى أداة رقابية قادرة على مواجهة التضليل بنفس الأدوات التي أُنتج بها.

خوارزميات كشف التزييف العميق

تطورت أدوات كشف التزييف العميق لتشمل تحليلًا دقيقًا لملامح الوجه وتغيرات الضوء والظل وحركة الشفاه.

تستطيع بعض النماذج الحديثة اكتشاف الفبركة بنسبة تفوق 95٪ عبر رصد أنماط دقيقة لا يلاحظها الإنسان.

كما يجري تطوير أنظمة فحص في الوقت الفعلي يمكن دمجها داخل منصات التواصل، فتُعلم المستخدم فور اكتشاف التلاعب البصري أو السمعي.

ومع ذلك، تبقى معركة الذكاء الاصطناعي ضد التزييف سباقًا مستمرًا بين التطوير والكشف.

التحليل الدلالي كمفتاح للتمييز بين الحقيقة والزيف

تتجاوز تقنيات التحقق الجانب البصري إلى تحليل السياق والمحتوى.

فعبر دراسة الترابط المنطقي بين الجمل وتاريخ النشر والمصدر، يمكن للنظام اكتشاف التناقضات الدلالية في الأخبار المزيفة.

على سبيل المثال، قد يُميز النظام بين تقرير صحفي حقيقي وآخر مزيف من خلال اختلاف الأسلوب أو غياب التفاصيل الواقعية.

بهذا، يتحول الذكاء الاصطناعي إلى قارئ ناقد، لا مجرد أداة مطابقة بيانات.

الأبعاد الأخلاقية والقانونية لصناعة الزيف

تثير القدرة على توليد المحتوى المزيف تحديات عميقة تتعلق بحرية التعبير والمساءلة.

من يتحمل المسؤولية عن مقطع مزيف يُنشر على نطاق واسع؟ المبرمج؟ المنصة؟ أم المستخدم؟

تحاول التشريعات الحديثة وضع أطر قانونية تُلزم الجهات التقنية بإضافة علامات مائية رقمية للمحتوى الاصطناعي.

لكن تطبيق هذه القوانين يظل صعبًا في ظل سرعة الانتشار وتعدد الجهات المنتجة للمحتوى.

الذكاء الاصطناعي والصحافة المسؤولة

في المقابل، بدأت المؤسسات الإعلامية في استخدام الذكاء الاصطناعي لتعزيز مصداقيتها.

تُستخدم الأنظمة الذكية في التحقق من الصور، وإدارة قواعد بيانات الحقائق، وحتى في كتابة التقارير اعتمادًا على مصادر موثوقة.

كما يجري تطوير أدوات مفتوحة تمكّن الصحفيين من كشف التزييف بسرعة، مما يعيد الثقة إلى العمل الصحفي في العصر الرقمي.

الذكاء الاصطناعي، بهذا الاستخدام الواعي، يصبح شريكًا في حماية الحقيقة لا تهديدًا لها.

نحو منظومة توازن بين الابتكار والمصداقية

التحدي الحقيقي لا يكمن في وقف الذكاء الاصطناعي، بل في توجيهه أخلاقيًا.

فالقدرة على توليد المحتوى يجب أن ترافقها مسؤولية في الإفصاح والشفافية.

ينبغي أن تتبنى الشركات الإعلامية والتقنية مبدأ “الشفرة الأخلاقية للذكاء الاصطناعي” الذي يحدد حدود الاستخدام المسموح.

عندها فقط يمكن للتكنولوجيا أن تظل خادمة للحقيقة لا أداة لتقويضها.

معركة الخداع والوعي

يعيش العالم اليوم صراعًا غير متكافئ بين سرعة الزيف وبطء التحقق.

لكن الحل لا يكمن في كبح التكنولوجيا، بل في تمكين الإنسان من فهمها ومساءلتها.

حين يدرك الجمهور آلية عمل الخوارزميات ويستخدم أدوات التحقق بوعي، تتقلص مساحة التضليل تدريجيًا.

الذكاء الاصطناعي سيبقى ساحة مزدوجة الاستخدام، لكن الرهان الأكبر يظل على وعي الإنسان في تمييز الحقيقة من الوهم.