تعاني الأمراض النادرة من قلة التشخيص الدقيق بسبب محدودية الخبرة السريرية والبيانات. مع ظهور الذكاء الاصطناعي، أصبح بالإمكان تحليل كميات ضخمة من البيانات البيولوجية والسريرية لاكتشاف أنماط خفية لا يمكن للبشر رصدها بسهولة.

لكن رغم هذه الفوائد، لا تزال الأسئلة الأخلاقية قائمة. كيف نضمن أن تكون هذه الأنظمة عادلة وآمنة؟ وما مدى موثوقيتها حين تكون البيانات شحيحة؟ يسلط هذا المقال الضوء على أبرز هذه التحديات.

صعوبة تدريب الأنظمة على حالات نادرة

يعتمد الذكاء الاصطناعي على توفر بيانات كثيرة للتعلم الفعّال. وبما أن الأمراض النادرة لا تظهر إلا في عدد محدود من الحالات، يصعب توفير بيانات كافية. يؤدي ذلك إلى بناء نماذج ضعيفة التعميم.

عندما تعمل هذه النماذج على عينات قليلة، تصبح احتمالية إصدار تشخيصات خاطئة عالية. وفي حالات حرجة، قد يؤدي الخطأ إلى تأخير العلاج أو اتخاذ قرار طبي غير ملائم.

الانحياز في البيانات وتأثيره على النتائج

إذا جاءت بيانات التدريب من مجموعة سكانية محددة، مثل مرضى من دول أو خلفيات عرقية معينة، فقد لا تتمكن الخوارزمية من التعرف على نفس المرض في مجموعات مختلفة.

هذا الانحياز يولّد فجوة في التشخيص بين فئات المرضى. لذلك، من الضروري أن تشمل البيانات التدريبية عينات متنوعة تمثل الجنسين، والأعمار، والأصول الجغرافية والثقافية المختلفة.

مشكلة التفسير: فهم القرار الطبي

تعتمد معظم نماذج الذكاء الاصطناعي على خوارزميات معقدة يصعب تفسيرها. قد يتلقى الطبيب نتيجة نهائية دون أن يعرف كيفية وصول النظام إليها.

في مجال الطب، لا تكفي النتيجة وحدها. يحتاج الطبيب إلى فهم السياق وراء التشخيص لتقديم الشرح للمريض، ولمناقشة الخطوات التالية. لذا يجب تطوير أدوات “تفسير القرار” كجزء أساسي من كل نظام.

من يتحمل مسؤولية القرار الخاطئ؟

إذا اعتمد الطبيب على النظام الذكي واتخذ قرارًا خاطئًا، فمن يُحاسب؟ هل تقع المسؤولية على الطبيب وحده؟ أم على مطوّر البرنامج؟

لمنع الغموض، يجب وضع إطار قانوني يحدد المسؤوليات بوضوح. كما يجب تدريب الأطباء على فهم حدود هذه الأنظمة، واستخدام نتائجها كمساعدة وليست بديلاً عن حكمهم المهني.

أهمية التواصل الإنساني في التشخيص

يعجز الذكاء الاصطناعي عن تقديم الدعم العاطفي، أو فهم السياقات النفسية والاجتماعية التي يعيشها المريض. لهذا السبب، لا يمكن للتكنولوجيا أن تحل محل العلاقة الإنسانية بين الطبيب والمريض.

يحتاج المرضى، خصوصًا في حالات الأمراض النادرة، إلى طبيب يسمعهم ويفسر لهم وضعهم الصحي بلغة يفهمونها. ويبقى دور الطبيب مركزيًا في هذه العلاقة.

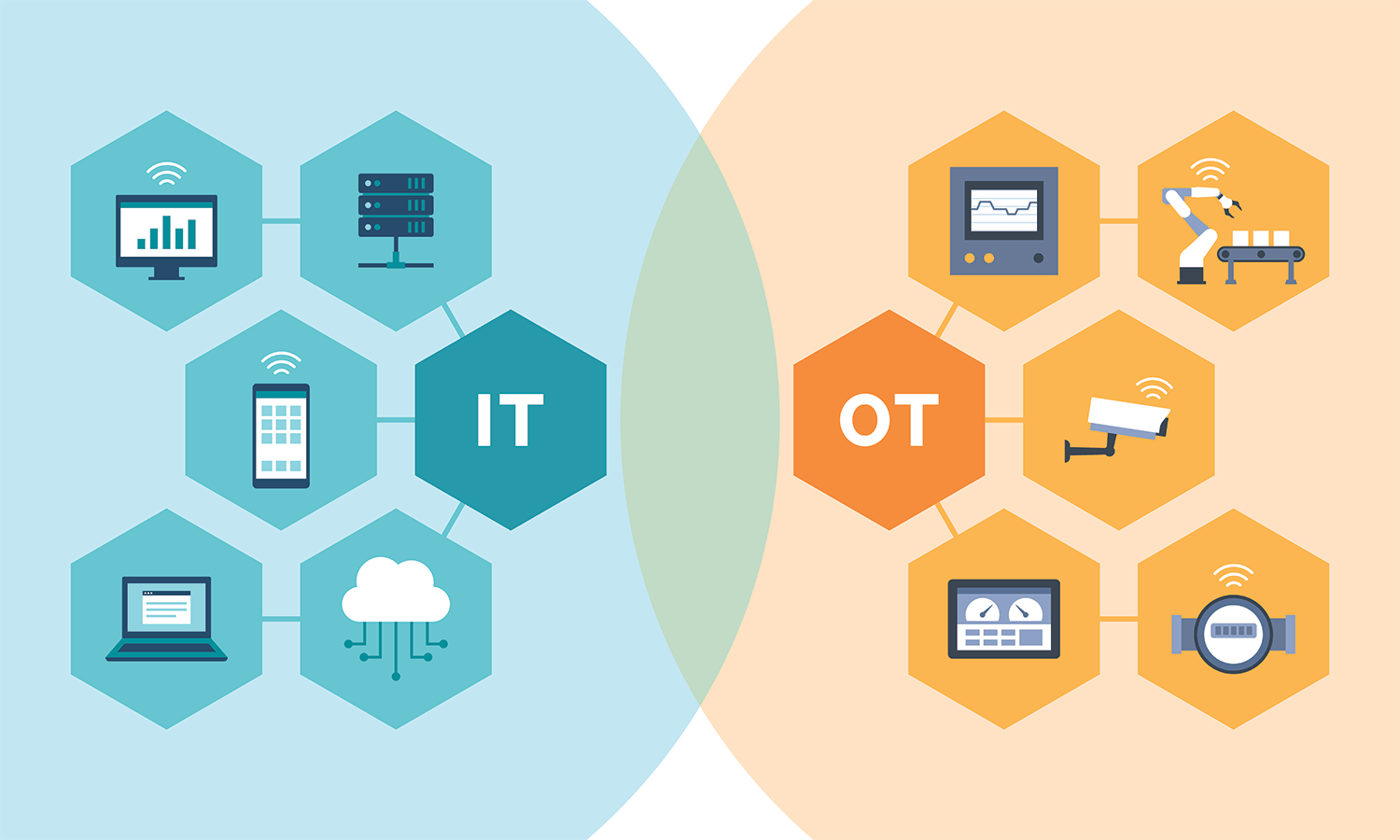

فجوة الوصول: من يحصل على الذكاء الاصطناعي؟

تتوفر أدوات التشخيص الذكية في المستشفيات المتقدمة غالبًا، لكنها تظل نادرة في المناطق النائية والبلدان النامية. يؤدي هذا إلى خلل في فرص الحصول على تشخيص دقيق.

إذا لم تُتاح هذه التكنولوجيا للجميع، قد تزيد الفوارق الصحية بدلًا من تقليصها. يجب أن تعمل الجهات المعنية على نشر هذه الأدوات بشكل عادل، وعدم حصرها في بيئات معينة.

حماية البيانات الشخصية في بيئة طبية

تشمل بيانات المرضى معلومات حساسة جدًا، خصوصًا في حالات الأمراض النادرة التي يمكن تتبع هوية صاحبها بسهولة. لذا يجب أن يحصل المرضى على تحكم كامل في بياناتهم.

يجب على المؤسسات الطبية الحصول على موافقة واضحة قبل استخدام هذه البيانات، وتوضيح كيفية تخزينها ومشاركتها. كذلك، ينبغي تمكين المرضى من سحب موافقتهم في أي وقت.

خطوات نحو ذكاء اصطناعي أخلاقي في التشخيص

يمكن تقليل هذه التحديات عبر اعتماد ممارسات أكثر مسؤولية، مثل:

- تدريب النماذج على بيانات أكثر تنوعًا وتمثيلًا.

- إدماج أدوات تفسير القرار في كل نظام ذكاء اصطناعي طبي.

- عدم الاعتماد على الخوارزمية وحدها، بل دمجها داخل عملية التشخيص الإكلينيكي.

- ضمان العدالة في الوصول إلى هذه التقنيات.

- صياغة قوانين تحمي الخصوصية وتوضح المسؤولية القانونية.

يشكّل الذكاء الاصطناعي فرصة مهمة لتحسين تشخيص الأمراض النادرة، لكنه ليس معصومًا من الخطأ. يحمل هذا التقدم في طياته مسؤولية أخلاقية ومهنية، تتطلب الحذر والشفافية.

لا ينبغي أن نسمح للتكنولوجيا أن تُقصي العنصر الإنساني في الطب. بل يجب أن توظف لمساعدة الأطباء، لا استبدالهم. بهذه الطريقة فقط، يمكن للذكاء الاصطناعي أن يعمل لصالح الإنسان، وليس على حسابه.