الذكاء الاصطناعي كحارس للأسرة الرقمية

تزايد اعتماد الأسر على أدوات المراقبة الذكية لمتابعة ما يفعله الأطفال على الإنترنت.

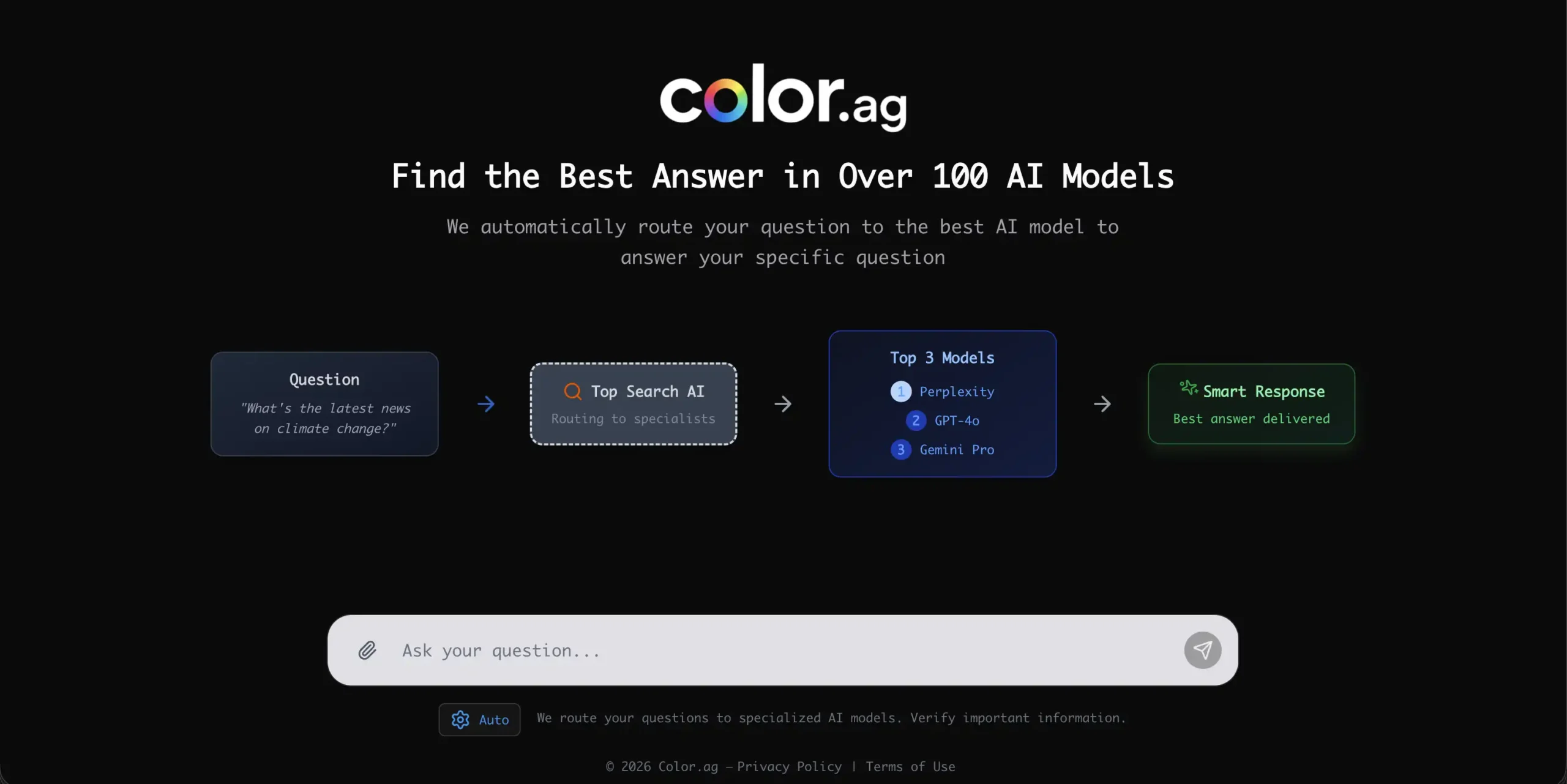

من تطبيقات التتبع الزمني إلى أدوات تحليل المحادثات، تعمل خوارزميات الذكاء الاصطناعي على تحديد المحتوى الضار أو التفاعلات المشبوهة قبل أن تصل إلى الطفل.

تعتمد هذه الأنظمة على تحليل الكلمات، الصور، وأنماط الاستخدام للكشف عن التنمّر الإلكتروني أو محاولات الاستغلال.

لكن ما يبدو وسيلة للحماية قد يتحول بسهولة إلى نظام مراقبة دائم يحدّ من حرية الطفل الرقمية.

الخوارزميات التي تعرف ما يفكر فيه الطفل

تعتمد الأنظمة الذكية الحديثة على تحليل السلوك بدلاً من الاكتفاء بالمحتوى.

فهي تراقب عدد الساعات أمام الشاشة، توقيت النشاط، وحتى التغيّرات في طريقة الكتابة أو سرعة الردّ، باعتبارها مؤشرات على القلق أو العزلة.

تستخدم هذه البيانات لتقدير الحالة النفسية للطفل أو احتمال تعرضه لمضايقات إلكترونية.

ورغم أن هذه القدرات قد تنقذ أطفالًا من مخاطر حقيقية، إلا أنها تثير سؤالًا أساسيًا: هل يجب أن يعرف النظام مشاعر الطفل ليحميه؟

من الحماية إلى التقييد

تتحول بعض أنظمة المراقبة أحيانًا من أداة وقاية إلى وسيلة سيطرة.

حين تفرض التطبيقات قيودًا تلقائية على الوصول إلى المحتوى أو تحدد وقت الاستخدام دون استشارة الطفل، فإنها قد تُشعره بالعجز لا بالأمان.

الأطفال في هذه الحالة يتعلمون إخفاء سلوكهم بدلاً من تطوير وعي ذاتي تجاه الاستخدام المسؤول للتقنية.

وهذا يقوّض الهدف الأساسي من المراقبة: بناء علاقة ثقة رقمية بين الطفل والوالدين.

بين الخوارزميات والأبوة الرقمية

الذكاء الاصطناعي يمكن أن يكون مساعدًا فعالًا للآباء، لكنه لا يستطيع استبدال الدور الإنساني في التربية.

فالقرارات الأخلاقية المتعلقة بما هو مناسب أو غير مناسب للطفل لا يمكن برمجتها بالكامل.

يجب أن تبقى الأدوات الذكية وسيطًا للمساعدة، لا بديلًا عن التواصل المباشر والتوجيه الأبوي.

التربية الرقمية الناجحة تقوم على الحوار وليس فقط على المراقبة التقنية.

الخصوصية العائلية في عصر البيانات

المراقبة المستمرة لا تؤثر على الطفل وحده، بل على الأسرة بأكملها.

تخزين البيانات العائلية – مثل سجل التصفح والمحادثات – في خوادم الشركات يمثل خطرًا حقيقيًا على الخصوصية.

ففي حال تسريب هذه المعلومات أو إساءة استخدامها تجاريًا، يمكن أن تكشف تفاصيل حساسة عن العادات العائلية والحياة اليومية.

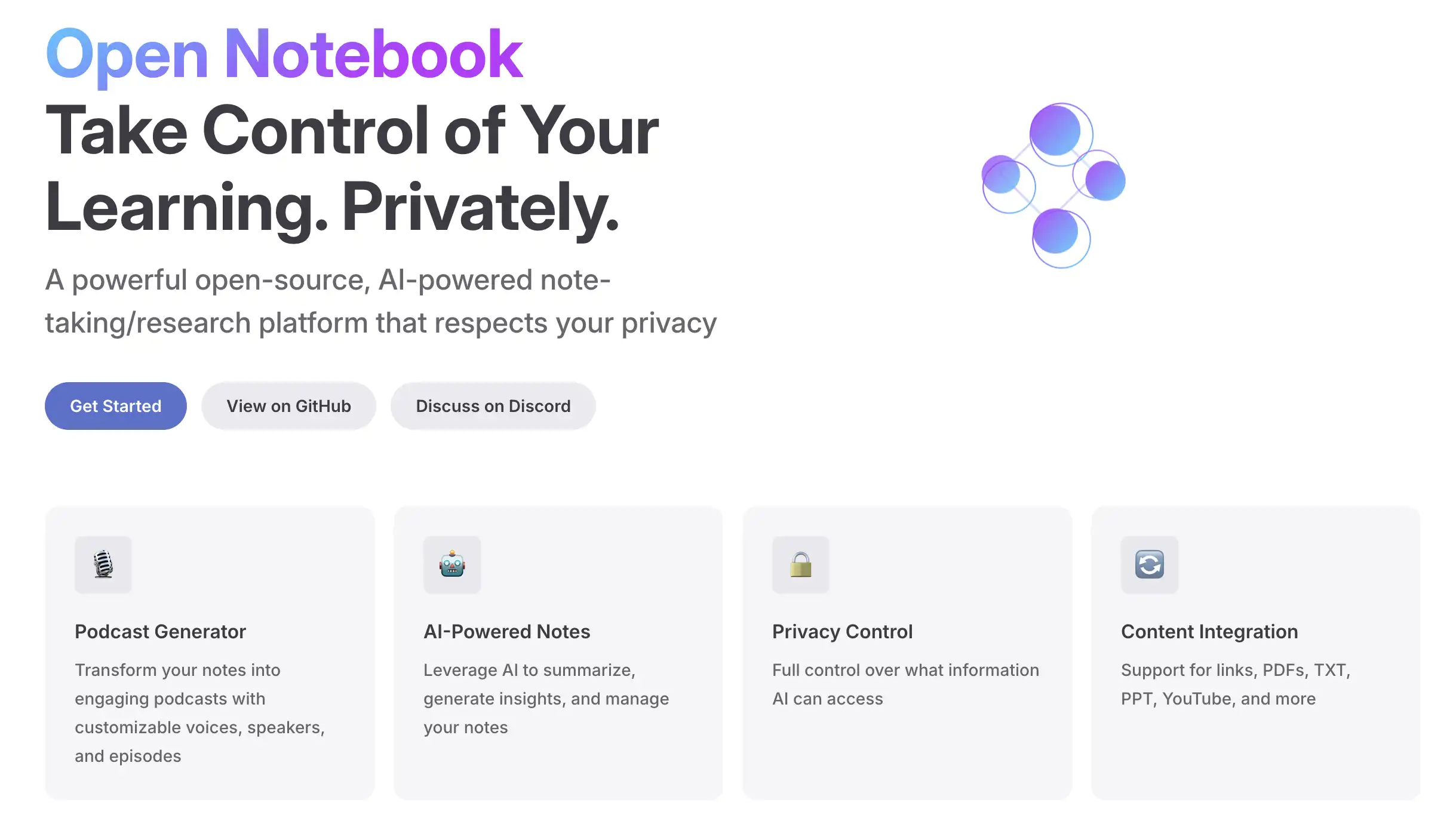

لهذا السبب، بدأ الاتجاه نحو المراقبة المحلية (On-device Monitoring) التي تحتفظ بالبيانات داخل الأجهزة المنزلية دون إرسالها إلى الإنترنت.

الذكاء الاصطناعي بين الرعاية والتطفل

الفارق بين الحماية والتطفل في الأنظمة الذكية يعتمد على شفافية التصميم.

إذا كان الطفل لا يعرف أنه مراقَب، تتحول التقنية إلى شكل من أشكال الانتهاك غير المرئي.

أما عندما تكون المراقبة واضحة ومفهومة، فإنها تصبح فرصة لتعليم الطفل مفهوم الأمان والمسؤولية الرقمية.

لذلك، تدعو المؤسسات الحقوقية إلى إلزام الشركات بإظهار آليات جمع البيانات وتوضيح كيفية استخدامها، ليبقى الحق في المعرفة محفوظًا حتى للأطفال.

التعلم الآلي كسلاح مزدوج

يمكن للخوارزميات نفسها التي تراقب المحتوى أن تُستخدم لتصنيف سلوك الأطفال بطرق قد تكون منحازة.

على سبيل المثال، قد تعتبر بعض النماذج سلوكًا طبيعيًا “خطِرًا” بسبب اعتماده على بيانات تدريب محدودة ثقافيًا أو اجتماعيًا.

وهذا يؤدي إلى فرض رقابة غير عادلة على بعض الفئات من الأطفال.

تؤكد هذه التحديات ضرورة إشراف بشري مستمر لضمان أن تبقى التقنية وسيلة للحماية لا أداة تمييز أو تصنيف.

نحو رقابة تشاركية لا سلطوية

التطور الحقيقي في مجال الأمان الرقمي للأطفال يكمن في إشراكهم في تصميم الحلول نفسها.

حين يفهم الطفل كيف تعمل الخوارزميات، يصبح قادرًا على حماية نفسه دون شعور بالخوف أو العزلة.

كما يمكن دمج أدوات تعليمية داخل تطبيقات المراقبة لتشجيع السلوك الإيجابي بدل العقاب الآلي.

بهذا، تتحول المراقبة من سلطة خفية إلى تجربة تعليمية تشاركية.

طفولة رقمية آمنة وإنسانية

يجب أن يُنظر إلى الذكاء الاصطناعي في سياق حماية الأطفال كأداة توازن، لا كجدار مراقبة.

فالهدف ليس تقييد الوصول، بل تمكين الأطفال من العيش بأمان داخل العالم الرقمي مع احترام خصوصيتهم ونضوجهم الذاتي.

عندما تُبنى الأنظمة الذكية على مبادئ الثقة والشفافية، يمكنها أن تخلق طفولة رقمية أكثر وعيًا وأمانًا، دون أن تسرق من الطفل حقه في أن يخطئ ويتعلم بنفسه.