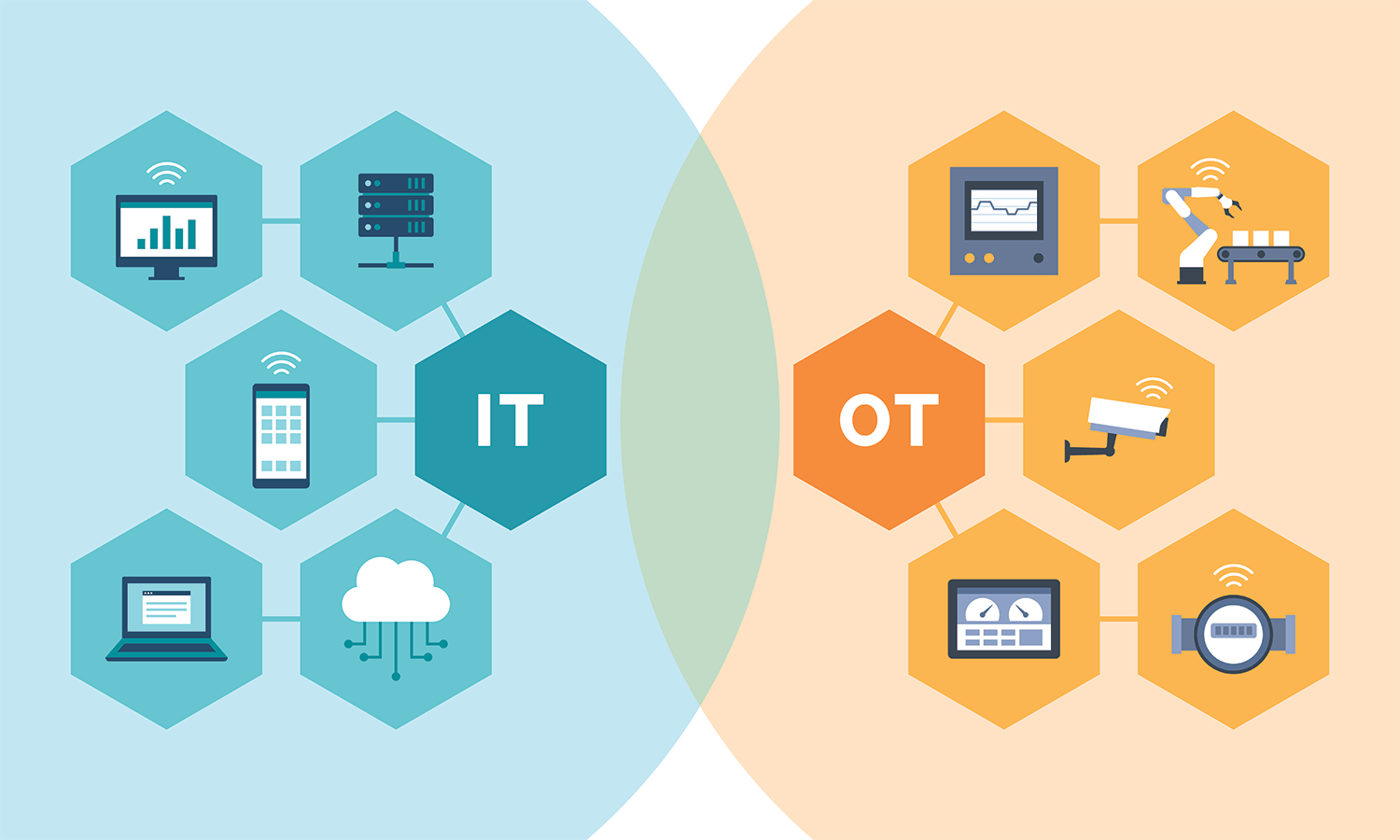

لم تعد الحملات الانتخابية تعتمد فقط على الإعلانات الجماعية أو المناظرات التلفزيونية. بدلاً من ذلك، صارت تعتمد بشكل متزايد على الذكاء الاصطناعي لتوجيه الرسائل السياسية.

تُحلل هذه الأنظمة بيانات المستخدمين من وسائل التواصل الاجتماعي وسجلات التصفح والسلوك الرقمي، ثم تستخرج منها أنماطاً سلوكية دقيقة. بعد ذلك، تُستخدم هذه الأنماط لبناء محتوى انتخابي موجّه لكل فرد على حدة.

كيف تُصمّم الخوارزميات الرسائل السياسية؟

الخوارزميات لا تكتفي بتحديد الآراء السياسية العامة، بل تذهب أبعد من ذلك. فهي تقيس العوامل النفسية والانفعالية، مثل الميل للتشاؤم أو الخوف أو الغضب.

على سبيل المثال، إذا أظهر المستخدم اهتمامًا بمحتوى يتعلق بالجريمة، تعرض له الخوارزميات رسالة تروّج لمرشح يدّعي أنه سيعزز الأمن. الرسالة لا تُقدَّم بصيغة مباشرة، بل تُدرج ضمن محتوى يومي يبدو محايدًا.

الإقناع عبر التكرار والتخصيص

تُكرر الرسائل السياسية بأساليب مختلفة وبصيغ متعددة. في كل مرة، تتغير اللغة أو الشكل، لكن تبقى الفكرة الأساسية واحدة.

بمرور الوقت، يبدأ المستخدم في تبنّي الفكرة دون أن يدرك أنه تعرض للتأثير المتكرر. هذه التقنية تُعرف بالإقناع الخفي. وهي أكثر فعالية لأنها لا تُقابل بمقاومة فكرية فورية.

بيئات مغلقة تولّد الانقسام

تستخدم المنصات خوارزميات توصية تعزز المحتوى الذي يفضّله المستخدم. ونتيجة لذلك، يتعرض الأفراد لمحتوى يؤكد قناعاتهم فقط، دون الاطلاع على الرأي المخالف.

تخلق هذه الظاهرة ما يُعرف بـ”الفقاعة المعلوماتية”. وهي بيئة رقمية مغلقة تُضعف النقاش العام وتُعزز الاستقطاب السياسي، لأن كل مجموعة تظن أنها تملك الحقيقة المطلقة.

أمثلة على استخدام الذكاء الاصطناعي سياسيًا

في الولايات المتحدة، أظهرت تقارير أن انتخابات 2016 تضمنت حملات استخدمت بيانات فيسبوك للتأثير على الناخبين المترددين.

في الهند، استُخدمت تطبيقات المحادثة لترويج أخبار كاذبة، بُنيت على تحليل سلوكي مسبق للناخبين. أما في البرازيل، فقد ظهرت حملات مخصصة تستهدف المجموعات الدينية برسائل تتناسب مع معتقداتهم.

غياب التنظيم القانوني

رغم خطورة هذا النوع من التأثير، لا تزال أغلب الدول تفتقر إلى تشريعات واضحة. لا تُلزم القوانين الحالية الحملات السياسية بالكشف عن طرق استهداف المستخدمين.

كما أن المنصات الرقمية غير مطالبة بتوضيح أسباب عرض محتوى سياسي معين، أو ما إذا كان قد بُني على بيانات سلوكية دقيقة.

كيف نحمي الديمقراطية من التلاعب؟

من الضروري فرض شفافية أكبر على الحملات السياسية الرقمية. يجب أن يعرف المستخدم كيف ولماذا يرى محتوى معين، خاصة إذا كان مرتبطًا بقرار انتخابي.

تحتاج الدول إلى تطوير تشريعات تُنظم استخدام الذكاء الاصطناعي في المجال السياسي. كما يجب إنشاء هيئات رقابية تراجع أدوات الاستهداف وتضمن احترام الخصوصية.

تثقيف المواطنين حول هذه الآليات يُعد خطوة مهمة أيضًا. كلما زاد الوعي، أصبح الأفراد أكثر قدرة على التمييز بين الرسائل المحايدة والدعائية.

الخاتمة

لا تكمن خطورة الذكاء الاصطناعي في قدرته على جمع البيانات فقط، بل في قدرته على استخدامها بطريقة دقيقة لتوجيه الوعي السياسي.

إذا استمرت هذه العمليات دون رقابة، فإن النتائج الانتخابية ستتأثر بعوامل خفية لا يدركها الناخبون. حماية الديمقراطية في العصر الرقمي تتطلب قواعد جديدة، وشفافية أكبر، ووعي مجتمعي واسع.