يشهد العالم توسعًا سريعًا في تطبيقات الذكاء الاصطناعي في القطاعات الأمنية، خاصة في ما يتعلق بالتنبؤ بالتهديدات قبل وقوعها. تعتمد بعض الجهات الأمنية على خوارزميات متقدمة لتحليل سلوك الأفراد والبيانات الرقمية، بهدف توقع النشاطات الإرهابية قبل تنفيذها.

ورغم ما تقدمه هذه التقنيات من فرص لتعزيز الأمن، إلا أنها تطرح تحديات أخلاقية وقانونية، تتعلق بحماية الخصوصية الفردية ومنع التمييز القائم على البيانات. تبرز هنا ضرورة التوازن بين تحقيق الأمان المجتمعي وضمان الحقوق الدستورية للمواطنين.

مفهوم الشرطة التنبؤية

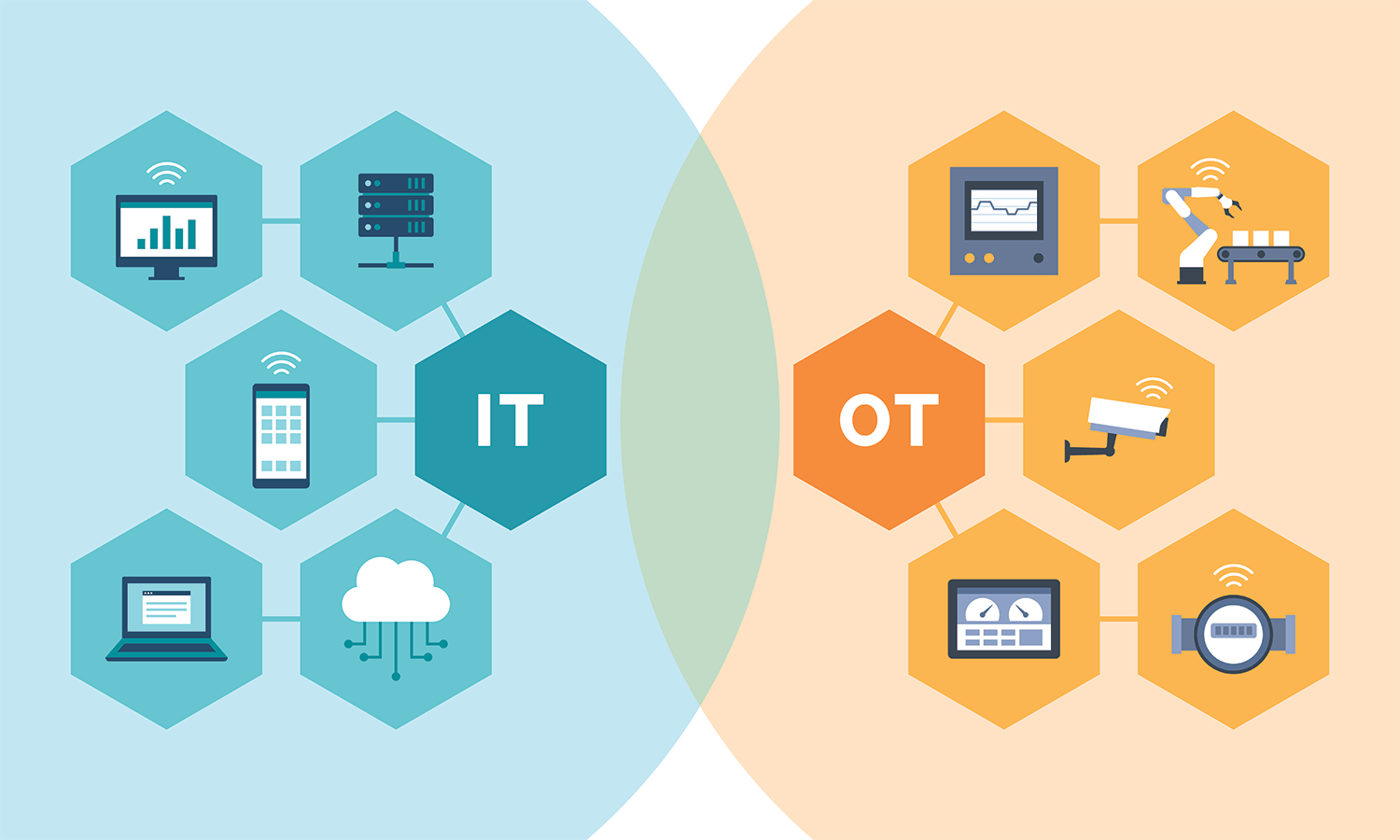

تقوم الشرطة التنبؤية على فكرة استخدام الذكاء الاصطناعي لتحليل البيانات والتنبؤ بالمخاطر المحتملة. تعتمد الخوارزميات على معلومات مثل أنماط السفر، المعاملات البنكية، الاتصالات الرقمية، ومحتوى وسائل التواصل. يهدف هذا التحليل إلى تحديد الأشخاص أو المناطق التي قد تشكل تهديدًا أمنيًا.

تدرّب الجهات الأمنية النماذج الحاسوبية على بيانات سابقة تتعلق بحوادث إرهابية، لتتمكن من التعرف على أنماط مكررة. بعد ذلك، ترصد هذه النماذج السلوكيات المشابهة وتصدر تنبيهات مبكرة، تساعد المسؤولين في اتخاذ قرارات استباقية.

حدود الدقة في النماذج التنبؤية

لا يمكن أن تعتمد الجهات الأمنية على الدقة الإحصائية وحدها عند تقييم أداء الخوارزميات. حتى لو حققت هذه النماذج معدل دقة عالٍ، قد يؤدي أي تصنيف خاطئ إلى انتهاك حقوق أبرياء. لذلك، تحتاج المؤسسات الأمنية إلى تقييم النتائج في سياق أخلاقي، لا فقط تقني.

تلعب جودة البيانات دورًا حاسمًا في تحديد دقة النموذج. إذ تؤثر البيانات الناقصة أو المنحازة سلبًا على مخرجات النموذج. على سبيل المثال، إذا درّبت السلطات النموذج على بيانات سابقة مشوبة بالتمييز، فإن النموذج سيكرر هذا التحيز تلقائيًا.

التحيز ومخاطر التصنيف الخاطئ

ترتكب بعض الخوارزميات أخطاء عندما تسيء تفسير سلوكيات بريئة على أنها مشبوهة، وذلك نتيجة تشابهها مع بيانات سابقة لمشتبه بهم. تؤدي هذه الأخطاء إلى ملاحقة أفراد دون دليل ملموس، مما يضر بالثقة العامة ويخلق شعورًا بالظلم.

كما قد تتوسع المراقبة لتشمل مجموعات سكانية معينة، بناءً على افتراضات خوارزمية لا تستند إلى تحقيق قضائي أو وقائع قانونية. في هذه الحالات، يهدد الأمن الآلي مبدأ المساواة أمام القانون.

الذكاء الاصطناعي والخصوصية الرقمية

تعتمد الخوارزميات التنبؤية على تحليل بيانات شخصية ذات طابع حساس، مثل الموقع الجغرافي، سجل البحث، وسلوك التفاعل الرقمي. ورغم أن بعض البيانات تُجمع من مصادر علنية، إلا أن دمجها وتحليلها يخلق صورة مفصلة عن الفرد، مما ينتهك خصوصيته.

يمكن للأنظمة الأمنية تقليل هذا الانتهاك باستخدام تقنيات خصوصية متقدمة، مثل التعلم الفيدرالي، الذي يسمح بتدريب النماذج على البيانات دون نقلها إلى خوادم مركزية. كما تساعد تقنيات التشفير والرقابة البشرية في ضبط استخدام البيانات ضمن الأطر القانونية.

الأمن والعدالة: معادلة صعبة

يسعى صناع القرار إلى تحقيق التوازن بين الأمان العام وحماية الحقوق الفردية، وهي معادلة معقدة في ظل تصاعد الاعتماد على الذكاء الاصطناعي. تدعو منظمات حقوق الإنسان إلى فرض رقابة على خوارزميات الشرطة، لضمان أنها لا تتجاوز سلطتها التقنية.

كما تطالب المؤسسات الحقوقية بإتاحة المجال للطعن في قرارات الخوارزميات، وفتح نماذجها للمراجعة المستقلة. يسهم ذلك في تعزيز الشفافية وضمان المساءلة.

تجارب واقعية وتطبيقات ميدانية

اعتمدت بعض المطارات أنظمة ذكية لتقييم مخاطر الركاب استنادًا إلى سلوكياتهم في نقاط التفتيش. في حالات عدة، أوقفت الأنظمة مسافرين أبرياء فقط لأنهم اشتروا تذاكر في وقت متأخر، أو تكرر سفرهم إلى وجهات معينة.

في مشروع أمني آخر، استخدمت وحدة مكافحة الإرهاب أدوات تحليل شبكات التواصل لتتبع علاقات رقمية بين الأفراد. اكتشف المحققون لاحقًا أن النظام جمع بيانات لآلاف المستخدمين غير المرتبطين بأي تهديد فعلي، مما أثار جدلاً حول شرعية الأسلوب.

نحو استخدام مسؤول للتقنيات التنبؤية

يمكن للمؤسسات الأمنية استخدام الذكاء الاصطناعي بفعالية إذا اتبعت مبادئ واضحة تحترم الحقوق. يجب أن تُصمَّم الخوارزميات وفق معايير الشفافية، وأن يُقيّم أداؤها بانتظام من قِبل جهات مستقلة.

كما ينبغي على الحكومات إشراك خبراء القانون، والأخلاقيات، والمجتمع المدني في مراحل تطوير واختبار هذه الأنظمة. ويجب أن تمتلك الجهات القضائية القدرة على مراجعة أي إجراءات قائمة على قرارات خوارزمية.

يملك الذكاء الاصطناعي إمكانيات هائلة في التنبؤ بالتهديدات الأمنية، لكنه لا يجب أن يُستخدم دون حدود. تؤثر هذه الأدوات بشكل مباشر على خصوصية الأفراد وثقتهم في المؤسسات. لذلك، تحتاج الجهات الأمنية إلى بناء نظام متوازن يدمج التقنية مع الحماية القانونية، ويضع الإنسان في صدارة الاهتمام.

الأمن الحقيقي لا يتحقق فقط عبر الخوارزميات، بل من خلال احترام القيم التي تضمن الاستقرار والعدالة والكرامة للجميع.