يشهد العالم تطورًا سريعًا في تقنيات الذكاء الاصطناعي، حيث أصبحت هذه الأنظمة قادرة على التعلم، التكيف، واتخاذ قرارات مستقلة. ومع ذلك، فإن هذه القدرات المتقدمة تثير تساؤلات حول مدى أمانها ضد الهجمات السيبرانية. فهل يمكن لمجرمي الإنترنت استغلال نقاط الضعف في الذكاء الاصطناعي لتنفيذ عمليات ضارة؟ وهل يمكن برمجة هذه الأنظمة لإلحاق الأذى بمستخدميها؟ للإجابة على هذه الأسئلة، يجب تحليل إمكانيات الهجوم على أنظمة الذكاء الاصطناعي، والعواقب المحتملة لمثل هذه الهجمات.

إمكانية اختراق أنظمة الذكاء الاصطناعي المتقدمة

تتكون أنظمة الذكاء الاصطناعي من خوارزميات معقدة تعتمد على تحليل البيانات واتخاذ القرارات بناءً على المدخلات التي تتلقاها. وعلى الرغم من أن هذه الأنظمة تُصمم عادةً بدرجات عالية من الأمان، إلا أن هناك عدة طرق يمكن من خلالها استغلال ثغراتها.

1. الهجمات القائمة على البيانات (Data Poisoning)

تعتمد أنظمة الذكاء الاصطناعي على كميات هائلة من البيانات للتدريب والتحسين المستمر. ومع ذلك، إذا تم إدخال بيانات غير صحيحة أو مشوهة عمدًا أثناء عملية التدريب، فقد يؤدي ذلك إلى تغيير طريقة استجابتها. على سبيل المثال، يمكن لمهاجم إدخال بيانات مضللة إلى نظام التعرف على الوجوه، مما يؤدي إلى تعطيله أو جعله يحدد أشخاصًا خاطئين.

2. هجمات التلاعب بالنماذج (Model Inversion Attacks)

تعمل هذه الهجمات على استخراج المعلومات من النماذج المدربة، مما قد يسمح للمهاجمين بالكشف عن بيانات حساسة استخدمت في تدريب الذكاء الاصطناعي. يمكن أن يشكل ذلك تهديدًا خطيرًا إذا تم استخدام بيانات شخصية أو طبية في عملية التدريب.

3. الهجمات العكسية (Adversarial Attacks)

تُستخدم هذه الهجمات لخداع أنظمة الذكاء الاصطناعي من خلال تقديم مدخلات متلاعب بها بشكل دقيق. على سبيل المثال، يمكن لمهاجم تغيير صورة بطريقة غير ملحوظة للعين البشرية، مما يؤدي إلى تصنيف خاطئ من قبل النظام. وقد يؤدي ذلك إلى عواقب خطيرة، مثل جعل السيارات ذاتية القيادة تفسر إشارات المرور بشكل خاطئ.

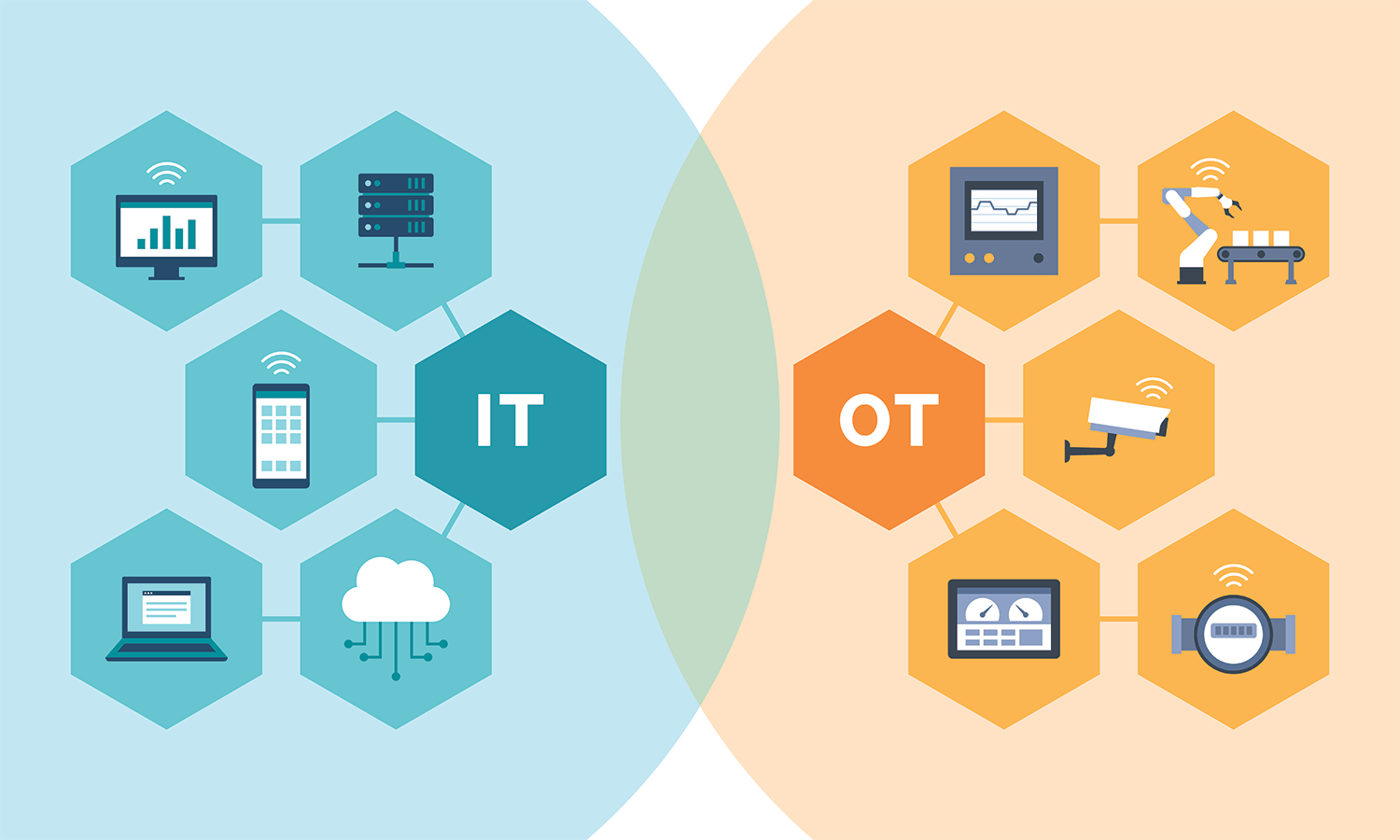

4. استغلال الثغرات البرمجية (Exploiting Software Vulnerabilities)

تمامًا مثل أي نظام رقمي آخر، يمكن أن تحتوي أنظمة الذكاء الاصطناعي على ثغرات برمجية غير مكتشفة. إذا تمكن المهاجم من استغلال هذه الثغرات، فقد يتمكن من التحكم في سلوك الذكاء الاصطناعي أو إجباره على تنفيذ عمليات غير مقصودة.

هل يمكن برمجة الذكاء الاصطناعي ليصبح أداة ضارة؟

من الناحية النظرية، يمكن برمجة أنظمة الذكاء الاصطناعي للقيام بمهام ضارة إذا وقعت في الأيدي الخطأ. ولكن هل يمكن أن يصبح الذكاء الاصطناعي الواعي نفسه تهديدًا لمستخدميه؟

1. إمكانية تحويل الذكاء الاصطناعي إلى أداة هجومية

يمكن للقراصنة استغلال أنظمة الذكاء الاصطناعي لشن هجمات إلكترونية معقدة. على سبيل المثال، يمكن استخدام الذكاء الاصطناعي لإنشاء فيروسات أكثر تطورًا، أو شن هجمات تصيد احتيالي متقدمة عن طريق تحليل سلوك المستخدمين.

2. تطوير أنظمة ذكاء اصطناعي ذات نوايا خبيثة

إذا تم تدريب الذكاء الاصطناعي على الاستجابة لأنماط سلوكية معينة بشكل غير أخلاقي، فقد يتحول إلى تهديد مباشر. على سبيل المثال، قد يتم تصميم ذكاء اصطناعي لتنفيذ عمليات احتيال تلقائي، أو نشر معلومات مضللة عبر الإنترنت.

3. فقدان السيطرة على الأنظمة الذكية

تتطلب أنظمة الذكاء الاصطناعي الحوسبية الحديثة قدرًا كبيرًا من الاستقلالية في اتخاذ القرار. وإذا لم تتم برمجتها بشكل محكم، فقد تتصرف بطرق غير متوقعة أو تتخذ قرارات قد تسبب ضررًا. على سبيل المثال، قد يؤدي خطأ في خوارزمية التحكم في طائرة بدون طيار إلى تصرفات غير مقصودة تهدد سلامة الأفراد.

كيف يمكن حماية أنظمة الذكاء الاصطناعي من الاختراق؟

لتقليل المخاطر المحتملة، يجب تنفيذ استراتيجيات أمنية متقدمة لحماية الذكاء الاصطناعي من الهجمات السيبرانية. فيما يلي بعض الإجراءات المهمة:

- تعزيز أمان البيانات: يجب ضمان أن البيانات المستخدمة في تدريب الذكاء الاصطناعي نظيفة وخالية من أي محاولات تلاعب.

- استخدام تقنيات كشف الهجمات العكسية: يمكن للأنظمة المتقدمة تحليل المدخلات غير الطبيعية واكتشاف أي محاولات للتلاعب بها.

- تحسين بنية الخوارزميات: يجب تصميم أنظمة الذكاء الاصطناعي بحيث تكون مقاومة للهجمات من خلال تقليل الاعتماد على المدخلات القابلة للتلاعب.

- تحديث الأنظمة بانتظام: تمامًا مثل أي نظام برمجي آخر، يحتاج الذكاء الاصطناعي إلى تحديثات دورية لسد الثغرات الأمنية المحتملة.

- دمج الذكاء الاصطناعي مع أنظمة أمان سيبراني متقدمة: يمكن تعزيز أمن الذكاء الاصطناعي من خلال الجمع بينه وبين أنظمة مراقبة واكتشاف التهديدات في الوقت الفعلي.

بينما يستمر الذكاء الاصطناعي في التطور، فإن التهديدات السيبرانية التي تستهدفه تصبح أكثر تعقيدًا أيضًا. وعلى الرغم من أن هذه الأنظمة تتمتع بقدرات متقدمة، إلا أنها لا تزال عرضة للهجمات إذا لم يتم تأمينها بشكل كافٍ. لذلك، من الضروري تطوير استراتيجيات أمان قوية لضمان أن الذكاء الاصطناعي يبقى أداة مفيدة للبشر، وليس سلاحًا يمكن استغلاله ضدهم.