من الروبوت الميكانيكي إلى الشريك الأخلاقي

تطورت الروبوتات من آلات تؤدي مهام محددة إلى كيانات قادرة على اتخاذ قرارات مستقلة ضمن بيئات بشرية معقدة.

لكن هذا التطور كشف حاجة جديدة: ليس فقط للذكاء الوظيفي، بل أيضًا للذكاء الأخلاقي.

في المصانع والمكاتب والمستشفيات، لم يعد الهدف أن تعمل الروبوتات بسرعة، بل أن تفهم حدود التفاعل البشري وتحترمها.

من هنا نشأ مفهوم “الروبوت الأخلاقي” الذي يوازن بين الكفاءة التقنية والمبادئ الإنسانية.

ما المقصود بالروبوتات الأخلاقية؟

الروبوت الأخلاقي هو نظام ذكي مبرمج على اتخاذ قرارات تراعي القيم الاجتماعية والقانونية والإنسانية.

يتضمن ذلك تجنّب الأذى، واحترام الخصوصية، وضمان العدالة في توزيع المهام والموارد.

يُبرمج هذا النوع من الروبوتات على تطبيق إطار أخلاقي (Ethical Framework) يشبه ما يُعرف في الطب بمبدأ “عدم الإضرار”، ولكن بصيغة رقمية.

فالخوارزمية لا تكتفي بتقييم الفعالية، بل تزن أيضًا أثر القرار على سلامة وكرامة العاملين.

الذكاء الاصطناعي والمسؤولية المشتركة في بيئة العمل

مع تزايد مشاركة الروبوتات في الوظائف الحساسة، بات من الضروري تحديد المسؤوليات بين الإنسان والآلة.

فعندما يتخذ الروبوت قرارًا يؤثر في سلامة العمل أو جودة الإنتاج، من يتحمل النتيجة؟

تسعى الأبحاث الحديثة إلى صياغة مفهوم “المسؤولية المشتركة”، حيث يتحمل النظام التقني والإنسان المشرف جزءًا من accountability.

هذا التوجه لا يهدف إلى تحميل الآلة ذنبًا، بل إلى بناء منظومة رقابة متبادلة تمنع الخطأ قبل وقوعه.

الأمان أولًا: كيف تحمي الخوارزميات الإنسان؟

في بيئات العمل المشتركة، يُعد الأمان أساس التفاعل الأخلاقي.

تستخدم الروبوتات الحديثة مستشعرات متعددة لرصد الحركة، والتعرف على الإيماءات، وضبط السرعة عند اقتراب الإنسان.

كما تُدمج خوارزميات التعلم المعزز الآمن (Safe Reinforcement Learning) لتعلّم تجنب السلوكيات التي قد تسبب خطرًا جسديًا أو نفسيًا.

بهذا، تتحول الأخلاقيات من مجرد قواعد نظرية إلى سلوك آلي فعلي داخل بيئة العمل.

التفاعل الإنساني والحدود العاطفية

العمل مع روبوت يتطلب إدراكًا خاصًا للفارق بين المساعدة والتطفل.

فعندما تُكلف الروبوتات بمهام الدعم البشري مثل المساعدة في الرعاية الصحية أو خدمة العملاء، يجب أن تفهم الفارق بين “الاقتراب المفيد” و”الاقتحام غير اللائق”.

تُستخدم نماذج الذكاء العاطفي الاصطناعي (Affective AI) لتحليل نبرة الصوت وتعابير الوجه وتعديل سلوك الروبوت وفق الحالة الشعورية للعامل.

هذا النوع من الوعي الاصطناعي لا يخلق تعاطفًا حقيقيًا، لكنه يضمن تفاعلاً آمنًا يحترم المشاعر البشرية.

التحيّز والعدالة في خوارزميات العمل

واحدة من أهم القضايا الأخلاقية هي خطر التحيّز في الأنظمة التي توزع المهام أو تقيّم الأداء.

فإذا كانت البيانات التدريبية منحازة، فإن الروبوت قد يكرر أنماطًا تمييزية في التقييم أو التعاون.

لذلك، تعتمد المؤسسات على نماذج “الشفافية الخوارزمية” التي تتيح تتبّع كيفية اتخاذ القرار داخل النظام.

الروبوت الأخلاقي لا يُبرمج فقط على الطاعة، بل على التفسير، أي أن يوضح سبب تصرفه ومرجعيته القيمية.

الثقة بين الإنسان والآلة: حجر الأساس للأخلاق الصناعية

لا يمكن أن ينجح أي نظام ذكي في بيئة العمل دون ثقة متبادلة بين الإنسان والآلة.

تُبنى هذه الثقة من خلال السلوك المتوقع والمستقر للروبوت، إضافة إلى وضوح حدوده الوظيفية.

عندما يدرك العامل أن الروبوت لن يتجاوز صلاحياته أو يخفي قراراته، يتعامل معه كشريك موثوق لا كمنافس.

بذلك، تتحول الأخلاق من برمجة داخلية إلى علاقة اجتماعية قائمة على الطمأنينة المهنية.

الأبعاد القانونية والتنظيمية

تسعى الهيئات الدولية إلى وضع معايير واضحة لاستخدام الروبوتات في بيئات العمل.

يتضمن ذلك تشريعات حول المسؤولية القانونية في حالات الخطأ، وحقوق الخصوصية للعاملين، وإجراءات السلامة عند التشغيل.

كما يجري تطوير “شهادات اعتماد أخلاقية” للروبوتات التي تُستخدم في قطاعات حساسة مثل الطب والتعليم.

هذه الأطر تهدف إلى ضمان أن الأخلاق ليست خيارًا تقنيًا، بل شرطًا أساسيًا للعمل الآلي المشترك.

مستقبل التعاون بين الإنسان والروبوت

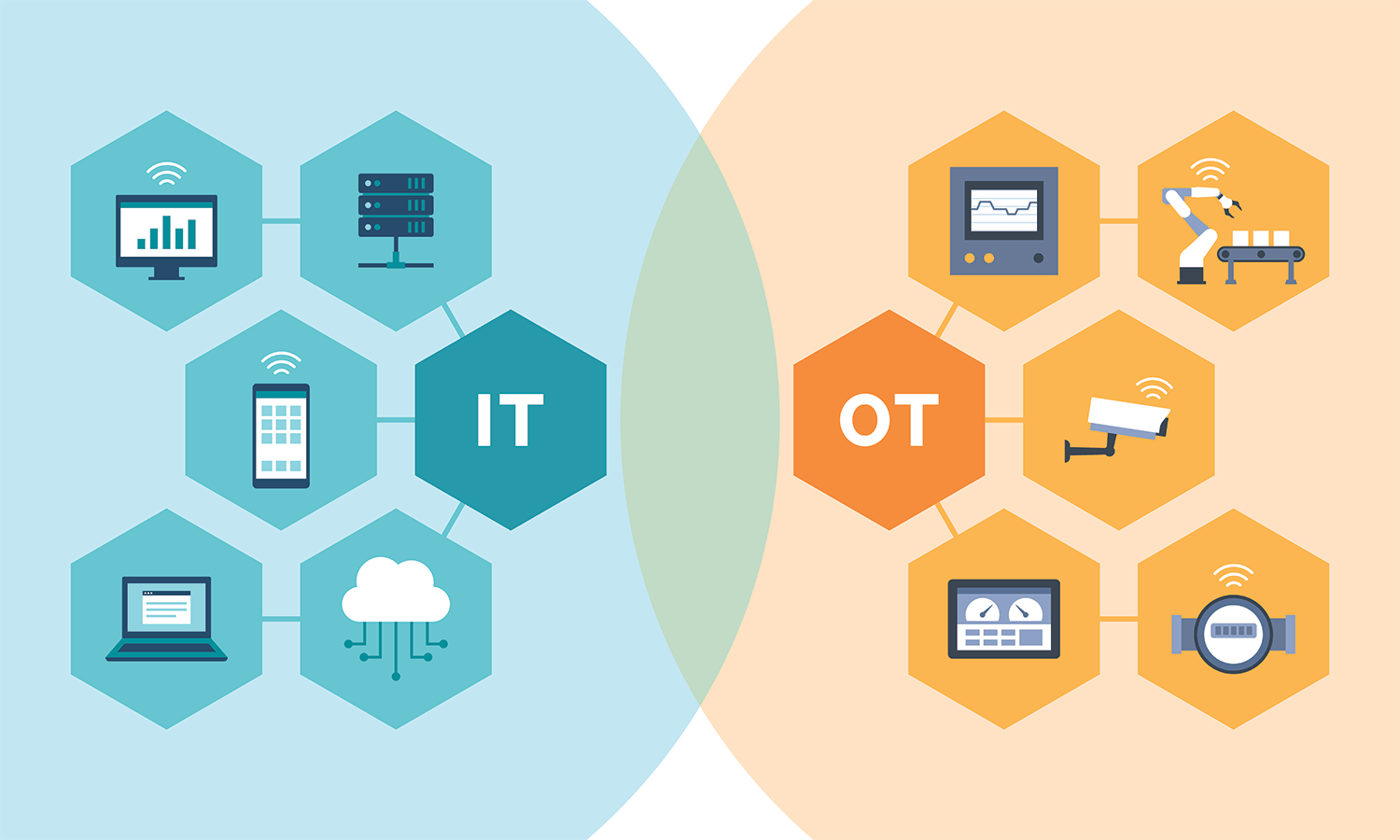

مع ازدياد الاعتماد على الروبوتات الأخلاقية، يتجه العالم نحو بيئة عمل تشاركية تدمج القدرات البشرية والإدراكية للآلة.

سيتحوّل دور العامل من منفّذ للمهام إلى مشرف على القرارات الذكية، بينما يتولى الروبوت الجوانب الخطرة أو المرهقة.

هذا التوازن يخلق منظومة إنتاج آمنة وإنسانية في آنٍ واحد، تُدار وفق مبدأ “الذكاء المسؤول”.

إنها ليست نهاية العمل البشري، بل بداية تعاون جديد تُكتب فيه القواعد الأخلاقية بلغة الخوارزميات.